Pédagogie et réussite une impossible quête ?

Article initialement publié sur une autre plateforme en janvier 2022

Février signifie la fin de la première session à l’université. La première session universitaire de toute leur vie pour la majorité de mes étudiants. Même si j’ai un plutôt bon souvenir de mes sessions d’examen, je sais bien que ce n’est pas une partie de plaisir pour la plupart de mes étudiants. Et les résultats en réjouiront certains mais seront une déception pour beaucoup. Déception qu’année après année, je partage d’une certaine manière. Je n’arriverai en effet jamais à m’habituer aux taux d’échec usuels à l’université. Petit partage des taux de réussite à mon cours, d’autres informations et de quelques réflexions.

Taux de réussite

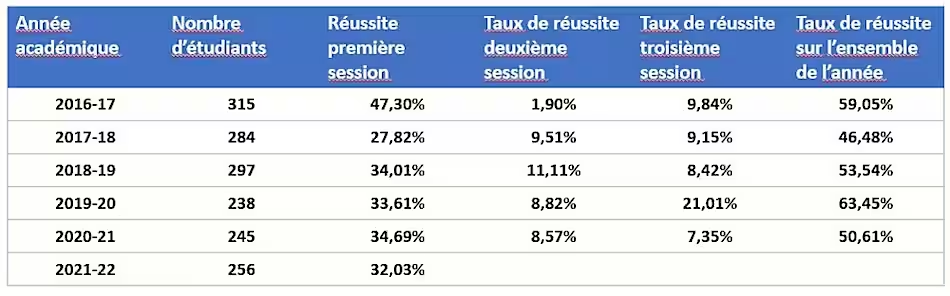

Commençons par les taux de réussite à mon examen ces dernières années. L’année académique 2021-22 n’est pas parfaitement comparable aux autres pour ce qui concerne le nombre d’étudiants. En effet, j’ai repris le nombre d’étudiants inscrits à l’une des trois sessions. Pour 2021-22, on ne sait pas encore combien d’étudiants viendront grossir les rangs lors des deux prochaines sessions sans s’être inscrits à la première. Le seuil de réussite est fixé à 10/20.

Première constatation, d’une année sur l’autre, la taille de la cohorte peut varier de manière assez importante. En dehors des variations dans les choix des étudiants, cela s’explique aussi par le fait que le cours d’économie politique se retrouve dans pas mal de cursus et les étudiants de cursus petit en nombre d’étudiants sont parfois changés de cours (il y a pas mal de cours d’économie politique qui sont donnés à l’UCLouvain) en fonction notamment des contraintes horaires. Cela veut donc dire que les cohortes ne sont pas parfaitement comparables.

Deuxième constatation, les taux de réussite peuvent parfois beaucoup varier sans que l’on sache toujours pourquoi. Pour la première session 2017-2018, de mémoire, c’est en partie lié au fait que j’ai écrit un set de question à choix multiple totalement nouveau alors que généralement une grande partie des questions sont des variations autour de questions se trouvant dans les examens précédents. Même si les QCM ne sont qu’une partie de l’examen, cela avait pas mal joué. Pour la troisième session de 2019-20, il n’y a aucun doute sur le facteur explicatif : la triche, examen en distanciel avec trop peu de contrôle. Cela ne s’est pas marqué pour la deuxième session de la même année qui était aussi en distanciel parce que j’avais posé une question très ouverte et à livre ouvert. La charge de travail pour corriger ce genre d’examen plus quelques autres contrariétés m’ont amené à un dispositif plus proche de celui de mes collègues pour la troisième session.

Troisième constatation, deux tiers des étudiants qui réussissent le font en première session. La correction des deux autres sessions est assez déprimante avec une part très importante de mauvaises copies. Cela est renforcé par le fait qu’aujourd’hui contrairement à ce qui se faisait auparavant, les étudiants peuvent présenter trois fois l’examen sur l’année (au lieu de deux précédemment). Il serait intéressant d’un jour étudier si cela aide vraiment les étudiants à réussir. J’aurais tendance à penser que c’est finalement une fausse bonne idée qui s’avère en pratique contre-productive (même si au départ, c’était une idée que je supportais complètement).

Quatrième constatation, une certaine stabilité depuis 2018-19. Et cela m’attriste parce que depuis 2019-20, j’ai largement remanié mon cours avec la production de beaucoup de ressources pédagogiques supplémentaires. Et cette année, le dispositif atteint une maturité qui me faisait espérer mieux même s’il faut toujours relativiser les chiffres. Par exemple, la proportion d’étudiants inscrits qui n’ont pas présenté l’examen est plus importante cette année que l’année dernière. Si l’on calcule le taux de réussite par rapport aux étudiants qui se sont présentés à l’examen, on obtient un meilleur taux de réussite cette année (38.86%) que l’année dernière (37.28%).

Même si les chiffres sont trop bruts et dépendants de trop de paramètres que pour tirer des conclusions définitives, ils ne sont pas très encourageants concernant l’intérêt de mon investissement ces dernières années dans l’amélioration du dispositif pédagogique.

Engagement des étudiants

Participation aux cours

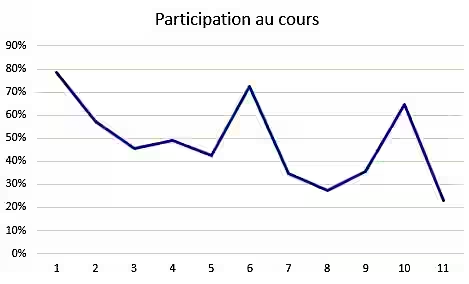

D’un autre côté, si l’on regarde la participation au cours, l’on se rend compte que seul une partie des étudiants s’investissent en pratique dans le dispositif pédagogique proposé.

Il y a évidemment de nouveau des questions de mesure. Hormis les mesures 6 et 10, j’utilise les données de Wooclap. Wooclap est un système de télévote sur lequel les étudiants sont invités à se connecter au début de la plupart des cours typiquement pour pouvoir répondre à des QCM pendant celui-ci. Un étudiant peut ne pas s’être connecté et un étudiant peut aussi s’être connecté à la fois à partir de son PC et de son smartphone. Plus le temps passe, moins les étudiants se connectent mais ce n’est pas une réalité absolue d’autant plus que parfois je les réinvite avec insistance à se connecter sur la plateforme. Pour les mesures 6 et 10, c’est beaucoup plus fiable parce que ce sont des tests certificatifs et que là, je compte les copies rendues. Notons également que le delta de temps entre chaque point de mesure n’est pas forcément une semaine. Durant certains cours, je n’utilise pas Wooclap et il peut y avoir deux cours sur la même semaine.

Cette année est plutôt une mauvaise année mais pas catastrophique. Vu les problèmes de mesure, il est toujours délicat de comparer les années entre elles mais j’ai l’impression que le taux de participation est un peu faible cette année sans que la différence ne soit très importante. Le onzième point de mesure tombe le dernier vendredi de la dernière semaine, un moment où l’on ne donne généralement pas cours parce que l’on sait que pour beaucoup, les étudiants seront déjà rentrés chez eux pour commencer le blocus. Cela peut poser question sur l’effectivité du calendrier académique mais aujourd’hui, c’est assurément une réalité que l’on ne peut pas nier.

20% d’étudiants que l’on n’a jamais vu. Dès le premier cours, 20% des étudiants sont absents. On peut penser que ce sont des étudiants bisseurs qui n’estiment pas nécessaire de venir au premier cours qui est perçu comme un cours d’introduction au système pédagogique proposé. Néanmoins, lors des tests certificatifs qui comptent chacun a priori pour 10% de la note finale, nous avons même une proportion plus importante que ces 20% qui ne se présentent pas le jour des tests. Lors du premier test, 28% des étudiants ne se sont pas présentés. A priori, on peut considérer qu’une toute grande majorité de ces 28% sont des étudiants qui ne s’investissent d’aucune manière dans le dispositif pédagogique proposé.

Tout au plus une moitié qui participe sur la longueur au cours. Une moitié qui participe peut sembler optimiste par rapport au graphique mais d’une semaine sur l’autre, ce ne sont pas forcément les mêmes étudiants qui sont présents. Je ne pense donc pas complètement fou de penser qu’une petite moitié est venue à plus de 70% des cours. Par contre, il y a optimisme sur la notion de participation qui pour certains se limite à la présence.

Un effet démotivant des tests certificatifs ? En préparant ce texte, j’ai été frappé par le fait que le taux de participation passe de 45% à 32% après le premier test. J’ai vérifié, en 2019-20, année où il y avait aussi eu un test certificatif, le taux de participation était passé de 47% à 34%. Une telle diminution ne se marque pas les années sans test. Cette observation est à prendre avec précaution vu le faible nombre d’observations mais elle ne manque pas de poser question.

On peut se demander où se situe la participation à mon cours par rapport aux autres cours. Malheureusement, je n’ai pas de chiffres pour comparer et l’on se rend compte que même les chiffres pour mon cours sont sujets à caution. Une comparaison des chiffres avec les autres cours ne semble donc pas aisée. Il y a quelques années, ce qui me paraissait un faible taux de participation me préoccupait pas mal et j’ai cherché à me rassurer sur le sujet. Le retour direct des étudiants ou par l’intermédiaire des assistants me pousse à penser que la participation à mon cours est dans la moyenne (voire moyenne supérieure) des cours qui se passent bien. Et mon expérience dans un autre cours m’a (malheureusement) appris que quand le cours se passe mal, la participation peut être bien plus faible.

Usage des ressources pédagogiques

Dans le cadre de mon cours, un grand nombre de ressources pédagogiques sont disponibles sur une plateforme Moodle et Moodle permet de suivre plus ou moins l’usage des ressources par les étudiants. C’est une autre possibilité d’appréhender la participation des étudiants au dispositif pédagogique.

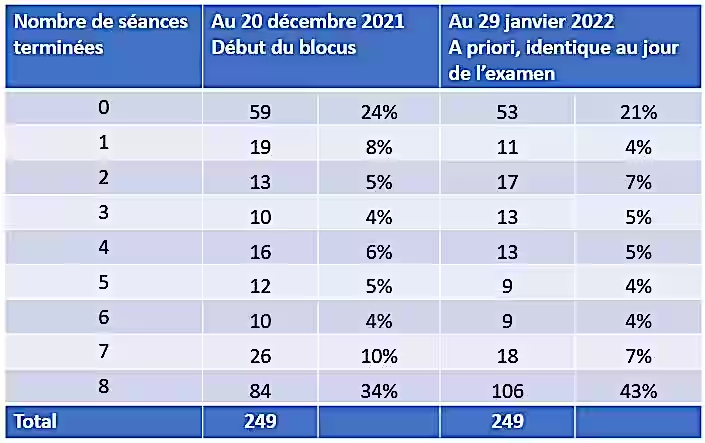

Mon cours comporte 8 séances à domicile qui sont des modules que les étudiants sont censés effectuer entre deux cours. Grosso modo, je peux savoir si les ressources de la séance (vidéos, textes, présentations commentées,…) ont été consultées. Je considère comme terminée une séance dont toutes les ressources suivies ont été consultées. Tout comme pour la présence au cours, c’est un indicateur faible de participation. Nous ne voyons pas la différence entre un étudiant qui a juste ouvert un document et celui qui l’a lu attentivement. Ces précautions méthodologiques mentionnées, voici ce que cela donne comme information:

Première constatation, 7 étudiants ne sont pas inscrits sur la plateforme Moodle. En effet, ici, je n’ai retrouvé que 249 étudiants alors qu’il y en a 256 d’inscrits à l’examen. Je pense qu’un seul de ces étudiants a présenté l’examen. Pour ces étudiants, peu de doute, ils ne se sont pas du tout impliqués dans le dispositif pédagogique proposé.

Deuxième constatation, on retrouve l’ordre de grandeur des proportions tirées de l’assistance au cours. Un quart d’étudiant qui ne s’inscrit aucunement dans le dispositif pédagogique. Plus ou moins la moitié participe réellement.

Troisième constatation, le blocus ne change pas tellement la situation. Si l’on regarde la proportion d’étudiants qui ont consulté toutes les ressources de 6 séances ou plus avant l’examen et en début de blocus, on passe de 120 étudiants à 133 étudiants. Ce n’est pas rien comme hausse mais c’est assez faible quand même. Les étudiants qui semblent avoir décrochés durant le quadri ne raccrochent pas réellement durant le blocus.

Engagement et réussite

Durant mes études, j’ai passé tout un examen à me demander si la surveillante était une assistante ou la titulaire du cours. Assurément, je n’avais pas été assidu à ce cours-là. Cela ne m’avait pas empêché de réussir plus qu’honorablement cet examen. Je n’en tire aucune fierté mais cette anecdote souligne bien que la participation au cours n’est pas a priori un prérequis à la réussite. Qu’en est-il pour mon cours ?

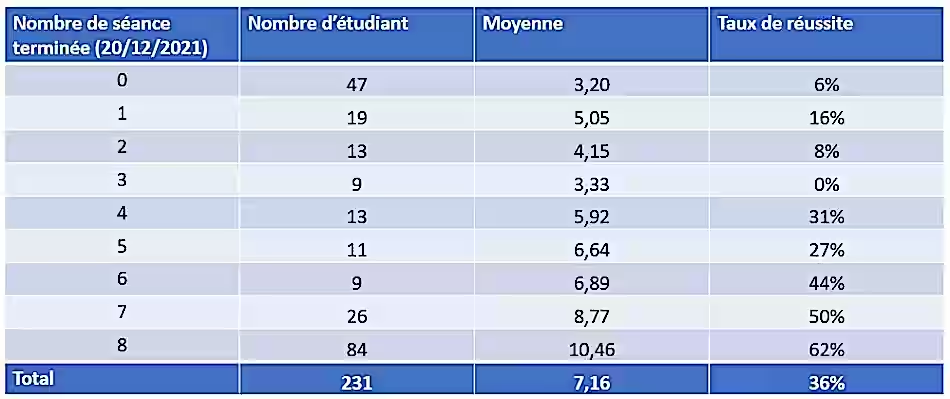

En croisant la réalisation des séances à domicile et les résultats à l’examen, j’obtiens le tableau suivant.

Je n’ai plus que 231 étudiants contre 249 dans le tableau précédent parce que je n’ai pas gardé les personnes absentes le jour de l’examen. C’est principalement dans la catégorie 0 séance terminée que l’on retrouve ces absents.

Des personnes qui réussissent avec un faible suivi du dispositif pédagogique, il y en a mais peu. 7 étudiants qui ont terminé 3 séances ou moins ont réussi. Cela donne un taux de réussite de l’ordre de 8% pour ceux qui se sont présentés à l’examen. Cela représente moins de 3% de la cohorte.

Le taux de réussite augmente significativement à partir de 6 séances terminées. Et ce taux est d’autant plus élevé que le nombre de séance terminée est élevé. Nous n’avons cependant pas assez d’information pour pouvoir attribuer cela au dispositif pédagogique. En effet, il est vraisemblable qu’il y ait aussi un phénomène de biais de sélection. Les bons étudiants ayant sans doute tendance à plus participer aux dispositifs qu’on leur propose.

La participation au dispositif pédagogique ne garantit pas la réussite. Même pour ceux qui ont terminé toutes les séances, le taux d’échec atteint 38%. Il est compliqué de savoir si c’est un taux compréhensible ou bien si on peut espérer une grande amélioration de celui-ci dans la mesure où l’indicateur de la participation est frustre et intègre certainement (mais dans quel ordre de grandeur ?) dans la catégorie bonne participation des personnes qui ne se sont que peu investies. Par exemple, je sais que certains étudiants cliquaient sur toutes les ressources dès qu’elles étaient disponibles sans pour autant réellement les consulter. Néanmoins, il y a certainement de la marge d’amélioration dans la capacité du dispositif pédagogique de mener à la réussite ceux qui l’ont suivi entièrement.

Et la docimologie ?

La docimologie est consacrée à l’étude du déroulement des évaluations et notamment à la façon dont sont attribuées les notes. En simplifiant et en caricaturant fortement, les évaluateurs ont tendance à toujours donner les mêmes notes avec la même distribution (une gaussienne) à un groupe indépendamment du niveau objectif du groupe. L’attribution des notes se font parfois plus par comparaison des copies entre elles que selon une grille de cotation objective. Une grille de cotation objective et pertinente est au demeurant très difficile à établir.

Évidemment, si chaque année le professeur attribue globalement les mêmes notes à son groupe d’étudiants, on ne pourra jamais voir dans les notes les progrès permis par l’amélioration de son dispositif pédagogique. Un tel phénomène peut-il se produire dans le cadre de mon cours ? La réponse est clairement oui.

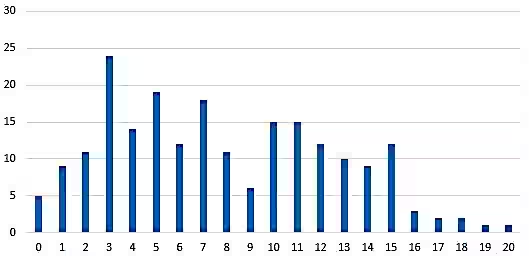

Si l’on regarde la distribution des notes, j’évite au moins la distribution gaussienne des résultats. (NB: par rapport aux tableaux précédents, il manque 20 étudiants avec une note de présence [0/20] dans le graphique ci-dessous.)

Quelques éléments qui nous prémunissent de la gaussienne: 1) Une partie de l’examen est un QCM qui est évidemment beaucoup moins susceptible de donner lieu à une gaussienne par goût du correcteur; 2) une grille de cotation est établie avant de corriger et certains éléments de cette grille ne sont pas du tout sujets à interprétation; 3) la plupart du quart des étudiants qui ne s’inscrivent pas dans le dispositif pédagogique (identifié plus haut dans le texte) rendent de très mauvaises copies, avec beaucoup d’absence de réponse.

Néanmoins, cela ne nous prémunit pas totalement contre le fait d’adapter d’une année sur l’autre le niveau de l’évaluation.

Premièrement, il est dans l’absolu difficile d’écrire deux examens de niveau de difficultés parfaitement équivalent. Des différences qui nous paraissent minimes ont parfois des effets étonnants sur les étudiants. Deux questions que l’on pensait parfaitement équivalentes peuvent parfois s’avérer très différentes aux yeux des étudiants. Par ailleurs, d’une année sur l’autre, la matière couverte n’est pas toujours identique et les bonnes années, des questions supplémentaires sont possibles par rapport à une mauvaise année. Je rechigne aussi à poser des questions sur une partie du cours où j’ai l’impression de ne pas avoir été bon le jour de son exposé en auditoire. S’il s’avère que cette partie du cours est une partie compliquée ou très simple pour les étudiants, cela impacte la difficulté finale de l’examen.

Deuxièmement, quand très peu d’étudiants donnent la bonne réponse à une question, il est sain de se poser la question de savoir si la question était adéquate. Il n’est pas question de supprimer une question ou de prendre une autre mesure corrective juste parce qu’elle est abondamment ratée par les étudiants mais je me pose chaque fois la question de savoir si cette question était bien alignée avec le dispositif pédagogique et avec les objectifs du cours. Si c’est le cas, je ne fais rien. Dans le cas contraire, j’adapte la cotation d’une manière ou d’une autre. Cette année par exemple, j’ai apporté deux (ce qui est beaucoup) changements à la cotation. Premièrement pour une question où tout au plus 5 bonnes réponses ont été données. Après réflexion, je pense que la question n’était pas bien formulée et qu’elle n’était pas parfaitement alignée par rapport à ce que j’avais enseigné. Deuxièmement, concernant le deuxième test certificatif. Ce test porte sur un modèle qui est généralement difficile à appréhender pour les étudiants. Le taux de réussite au test est d’ailleurs faible. Ce modèle est resté une part importante de l’examen en session. Cela veut dire que tel qu’envisagé, cette partie du cours comptait pour plus que les années précédentes dans l’examen (et donc que l’évaluation était sans doute globalement plus difficile).

Tout cela souligne combien il est difficile d’avoir une évaluation parfaitement identique, comparable d’année en année.

En guise de conclusion

Le nouveau dispositif pédagogique mis en place depuis 3 ans contribue-t-il à la réussite de mes étudiants ? C’est avec cette question en tête que j’ai commencé à un peu analyser les chiffres dont je dispose. Force est de constater que la conclusion n’est pas forcément encourageante vu qu’on observe au mieux une stabilité du taux de réussite.

Néanmoins, il n’est vraisemblablement pas possible de tirer des conclusions fortes à cause de tous les éléments perturbants possiblement les chiffres. La composition de la cohorte n’est pas identique d’une année à l’autre. Malgré tous mes efforts, il n’est pas simple d’avoir des évaluations parfaitement comparables au cours du temps. Le Covid n’a certainement pas aidé.

La relativement faible participation des étudiants signifie aussi que le dispositif pédagogique n’influe directement que sur une petite moitié des étudiants. Les autres ne participant pas suffisamment pour que l’on puisse espérer avoir sur eux un effet direct à travers l’organisation du cours. Il semble y avoir 25 % d’étudiants perdus. Sans doute qu’il serait nécessaire de creuser le sujet pour comprendre ce qui explique leur décrochage rapide et fort par rapport à ce qui est proposé. Je crains que l’on ne puisse pas faire grand-chose au niveau des cours pris individuellement et que c’est de manière plus globale que la situation de ces étudiants doit être abordée et traitée.

L’autre impact possible et peut-être prioritaire du dispositif pédagogique : augmenter la participation des étudiants. Quand je pense mon cours, je cherche à trouver la meilleure manière d’expliquer les choses avec implicitement en tête l’étudiant qui s’investit dans le dispositif que je lui propose. J’ai certainement raison de faire cela mais sans doute que je devrais faire (encore) plus attention à embarquer le maximum d’étudiants dans le dispositif.

Le point précédent n’est pas facile à réaliser. Si je propose des tests certificatifs en cours d’année c’est d’un côté parce que je pense que cela aide les étudiants à situer où ils en sont dans la maîtrise de la matière mais aussi parce que je croyais que cela permettait de motiver les étudiants à travailler de manière plus continue tout au long du quadri et pas à attendre le blocus pour s’y mettre. En restant prudent, il semble quand même que ces tests ont un effet démotivant. Comme c’est un élément que je viens de découvrir, je ne sais pas encore quoi en tirer comme conséquence mais assurément cela questionne pas mal mes convictions sur le sujet.